BIENVENUE

BTS SIO OPTION SISR

FAATUARAI MATAHIRA

DATA CENTER

Un centre de données ou data center est un site physique sur lequel se trouvent regroupés des équipements constituants du système d’information de l’entreprise (ordinateurs centraux, serveurs, baies de stockage, équipements réseaux et de télécommunications, etc.). Il peut être interne et/ou externe à l’entreprise, exploité ou non avec le soutien de prestataires

Actualités

Cisco ajoute des options de déploiement virtuel et cloud à son service Tetration

April 12, 2018

Avec des options de déploiement virtuel et dans le cloud, Cisco compléte son plateforme de traitement analytique de la sécurité des datacenters en temps réel Tetration Analytics. Après avoir remonté des informations de capteurs matériels et logiciels, le système Tetration traite ces données par de l’analyse big data et de l’apprentissage machine, permettant ainsi aux responsables IT de mieux comprendre les ressources de leur datacenter.

Tetration améliore la surveillance de la sécurité et simplifie la fiabilité des opérations. L’outil unique permet aussi aux clients de récolter des données télémétriques de sécurité cohérentes au niveau du datacenter et d’analyser de grands volumes de données en temps réel. Cette semaine, l’équipementier a donc complété son offre par Tetration SaaS, une option de cloud géré pour les grandes entreprises et par Tetration-V, une version logicielle de la solution tournant sur une appliance virtuelle, plutôt destinée aux opérations de moindre envergure.

Schneider Electric allie edge computing et efficience energétique

April 06, 2018

Engagée dans une profonde transformation de ses activités pour mieux répondre aux besoins des pays et des entreprises, Schneider Electric entend accélérer la convergence entre alimentation d’énergie et numérique. C’est en tout cas le principal message asséné par Jean-Pascal Tricoire, PDG de Schneider Electric : « L’électricité n’est pas le passé, et le numérique l’avenir. Les deux sont liés pour améliorer l’efficience énergétique ». Site pilote du fournisseur en matière de transformation numérique, l’usine de Vaudreuil, créée en 1975, en Normandie, a reçu le label Vitrine Industrie du Futur par l’AIF (Alliance pour l’Industrie du Futur). Cette usine expérimente l’apport du numérique pour optimiser la chaine de production avec par exemple des capteurs de CO2 pour ajuster le renouvellement de l’air et économiser l’énergie dédiée au chauffage.

La Nouvelle Aquitaine entend réunir ses ressources IT dans un datacenter régional

March 29, 2018

Au mois de juin 2017, l'Etat lance un appel à manifestation pour que chaque grande région universitaire crée un datacenter unique. Celles qui rempliront les critères définis recevront des concours financiers. La réponse arrive le 5 septembre. Trois universités ont répondu de manière satisfaisante (Auvergne Rhône-Alpes, Paca, Bourgogne France-Conté) et seront soutenus par l'Etat dans la construction de leur datacenter unique pour toutes leurs universités. Une autre région, n'est pas loin du but, mais n'entre pas dans cette labellisation, c'est la Nouvelle Aquitaine.

Les 9 compétences historiques recherchées par les entreprises

January 04, 2018

Les entreprises sont confrontées à un nouveau défi en raison d'un déficit de compétences grandissant. Il porte sur les compétences historiques ou legacy destinées à mettre à jour les anciennes technologies. Les entreprises sont confrontées à la nécessité d'embaucher sur des compétences qui ont tendance à disparaître du fait des départs en retraite. La mise à jour d'anciennes technologies a entraîné une perte de ressources, au fur et à mesure que les employés chevronnés quittent le marché du travail, les entreprises peuvent se trouver privées de compétences qui sont maintenant considérées comme dépassées, mais restent nécessaires.

Un sondage de Computerworld a révélé que 35% des entreprises recherchent toujours des compétences en programmation pour soutenir les systèmes legacy critiques. Voici les neuf technologies de type legacy pour lesquelles les entreprises recherchent des compétences.

Les baies flash et hybrides tirent le marché du stockage

December 13, 2017

Après rien de moins que dix trimestres consécutifs de recul, les ventes de systèmes de stockage externe sont reparties à la hausse en EMEA. Selon IDC, elles ont atteint 1,64 Md$ au troisième trimestre 2017, progressant ainsi de 10,33% (+4,8% en euros) par rapport à la même période de l'an dernier. L'Europe de l'Ouest a joué un rôle de premier plan dans la vigueur retrouvée du marché. Dans la région, les investissements des entreprises ont crû de 14,2% (+8,4% en euros). Ils ont également enregistré une hausse à deux chiffres en Europe Centrale et de l'Est mais baissé dans la zone Moyen-Orient et Afrique.

Un SDK Microsoft pour développer quantique

December 12, 2017

Apprendre à programmer un ordinateur quantique, c'est ce que propose Microsoft avec son Quantum Development Kit. Celui-ci est livré dans une préversion gratuite incluant le langage de programmation Q#, entièrement conçu pour l’informatique quantique, ainsi qu'un simulateur de calcul quantique et diverses ressources. Ce kit, dont l’arrivée avait été annoncée en septembre, ne s’adresse pas uniquement à des experts en physique quantique, assure Microsoft. Il est en effet étroitement intégré avec Visual Studio, ce qui en facilitera la prise en main à ceux qui utilisent déjà cette suite de développement.

ZFS au coeur des NAS open source d'iXsystems

December 08, 2017

En direct de San José - Beaucoup d’acteurs se disputent aujourd’hui le marché du NAS entreprise. Des systèmes utilisés pour le partage de fichiers en réseau mais également la sauvegarde, l'archivage et la récupération après sinistre. Concurrent de QNAP, Synology, Dell ou encore Thecus, iXsystems se distingue avec un ADN open source qui remonte à la création de FreeBSD. Relancée en 2002 après une histoire mouvementée avec Wind River Systems, iXSystems emploie aujourd’hui 130 personnes à San José, avec 40% d’ingénieurs et des techniciens pour monter localement les châssis des NAS et des JBOD. Interrogé sur la question de la sous-traitance, Brett Davis, exécutif vice-président, nous a répondu qu’une production interne était plus indiquée quand on voulait contrôler la qualité des produits. Nous vendons entre 5 et 10 000 NAS par an ».

IBM dégaine ses Power9 taillés pour le deep learning

December 05, 2017

Bâtis autour du processeur Power9, les nouveaux serveurs Power Systems AC922 d’IBM ont été conçus pour les charges de travail intensives requises par les technologies d’intelligence artificielle. Selon big blue, la puissance fournie permet d’accélérer les processus d’apprentissage avec les bibliothèques et frameworks de machine learning et deep learning les plus utilisés, tels que TensorFlow, Caffe et Chainer. Ce serait également le cas avec des bases de données spécialisées dans l’analyse en temps réel comme celle de Kinetica.

Pour obtenir ces performances, les serveurs AC922 embarquent notamment un bus PCI-Express 4.0, la nouvelle génération de liens d’interconnexion NVLink de Nvidia et un bus OpenCAPI. Combinés, ils font circuler les données 9,5 plus vite qu’avec un bus PCI-E 3.0 basé sur des systèmes x86, pointe IBM. Le fournisseur rappelle qu’il a commencé à travailler quatre ans plus tôt sur la conception de la puce Power9 « à partir d’une feuille blanche » avec l’objectif de bâtir une architecture capable de supporter les processus de machines learning nécessitant de prendre en charge les flux de données et les algorithmes d’IA sur des systèmes Linux.

Après 12 années passées chez AMD, comme CTO puis à la tête de l'activité Visual Computing, Raja Koduri, apporte sa longue expérience des technologies graphiques à Intel. Il est recruté au poste de chief architect, directeur général des solutions de edge computing.

November 09, 2017

Intel vient d’enlever à son concurrent AMD l’architecte en chef de son activité Radeon Technologies, Raja Koduri, pour le recruter comme vice-président senior de sa division Core & Visual Computing, nouvellement créée. Raja Koduri se voit attribuer les fonctions de directeur général des solutions de edge computing et le poste d’architecte en chef d’Intel Corporation. Il va conduire le développement du fournisseur californien sur le marché des solutions graphiques intégrées pour PC « pour une large gamme de segments informatiques », précise Intel dans le communiqué annonçant sa nomination.

Chez Intel, Raja Koduri sera également responsable de différentes technologies, tant graphiques, associées à l’imagerie et aux médias, que liées aux capacités d’intelligence artificielle, dans les datacenters et dans les environnements clients, de même que sur les segments émergents tels que les équipements situés en bout de réseau (edge computing). « Visionnaire et innovateur respecté, Raja Koduri a consacré sa carrière aux technologies de visualisation avancées et à l’accélération des traitements sur un vaste évantail de plateformes, PC, consoles de jeu, stations de travail professionnelles et terminaux grand public », souligne Intel.

12 ans chez AMD avec un intermède de 4 ans chez Apple

L'architecte en chef a passé 12 ans chez AMD qu’il a intégré en 2001 pour piloter le développement des technologies avancées et devenir le CTO du fabricant de processeurs. Il a ensuite rejoint Apple dont il a été d’avril 2009 à mars 2013 le directeur de l’architecture graphique. Il est ensuite reparti chez AMD pour superviser l’activité Visual Computing.

Lorsque Raja Koduri a quitté AMD cette semaine, les spéculations le disaient en partance pour Nvidia ou Intel, les deux autres rivaux sur le créneau graphique. « Nous avons des projets enthousiasmants pour étendre très sérieusement nos capacités informatiques et graphiques et bâtir sur notre solide propriété intellectuelle, étendue et diffférenciée », a déclaré Murthy Renduchintala, responsable de l’ingénierie d’Intel, dans un communiqué. « Avec Raja à la barre de notre groupe Core & Visual Computing, nous allons ajouter à notre portefeuille des capacités inégalées, faire avancer notre stratégie pour prendre la tête dans le graphisme et le traitement, et jouer un rôle moteur dans la révolution des données », se réjouit-il.

La progression globale du marché des solutions convergées est assurée dans son intégralité par le commerce de systèmes hyperconvergés qui affiche 48,5% de croissance.

October 02, 2017

A mesure que les systèmes convergés se démocratisent, la hausse de leurs ventes mondiales se fait de moins en moins forte. Au second trimestre 2017, elles ont représenté 3,15 Md$ de chiffre d'affaires, en hausse de 6,2% par rapport à la même période en 2016, selon IDC. D'une année sur l'autre, leur progression a ainsi été divisée par deux. Quant à la croissance des capacités de stockage livrées, elle n'a atteint que 5,6% à 1,78 pétaoctets entre avril et juin derniers, contre +32% un an plus tôt. D'après Eric Sheppard, analyste chez IDC, l'évolution positive que continue malgré tout de connaitre le marché est nourrie par « la disponibilité de produits offrant des niveaux supplémentaires d'automatisation, une intégration plus étroite entre les technologies embarquées, et, souvent, des solutions définies par logiciel basées sur des architecture évolutives. »

Dans le cadre du programme Entrepreneur d'Intérêt Général (EIG), le gouvernement français engagera 27 informaticiens en CDD de 10 mois à compter de janvier prochain. Sont concernés des développeurs, des data scientists, des géomaticiens, ainsi que des chefs de projet numérique.

September 28, 2017

Le gouvernement français ouvre un appel à candidatures pour le recrutement d’informaticiens extérieurs à l’administration afin de relever des défis liés à l’utilisation des données dans le secteur public et à la transformation numérique de l’État. Lancée dans le cadre du programme Entrepreneur d’Intérêt Général (EIG) initiée en 2016, cette campagne permettra à 27 professionnels du numérique d’être recrutés en CDD de 10 mois à compter de janvier 2018. Leur salaire mensuel s'élèvera à 4 000 euros nets. Les profils recherchés sont des développeurs, des data scientists, des designers, des géomaticiens, ainsi que des chefs de projet numérique.

Pour cette seconde promotion, 13 défis portés par des administrations pilotes ont été identifiés : lutte contre la fraude financière, ouverture du potentiel des données de la recherche, aide des sapeurs-pompiers, amélioration de la santé des Français, sauvetage des vies en mer, amélioration de la réussite scolaire. Les candidats sont invités à postuler sur le site d'EIG avant le 27 octobre 2017.

Ce programme est financé par le fonds « Transition numérique de l’État et modernisation de l’action publique » du Programme d’Investissements d’Avenir. Il est porté par la mission Etalab au sein du SGMAP, en lien avec le Commissariat général à l’investissement et la Caisse des Dépôts et Consignations.

Sur le marché de l'informatique quantique, Microsoft veut maîtriser l'ensemble de la pile, depuis la puce jusqu'à l'OS. Il développe dans le même mouvement le processeur et les langages de programmation.

September 25, 2017

L’informatique quantique figure en tête des priorités de Microsoftdepuis plusieurs années, ainsi qu'il l’avait exposé il y a un an. L’éditeur de Redmond vient de revenir sur le sujet à l'occasion de sa conférence Ignite, qui se tient du 25 au 29 septembre à Orlando. Ses équipes de R&D sont engagées dans un projet de développement de cette nature qui va des puces jusqu’au système d’exploitation pour essayer de contrôler cette technologie d’ordinateur disruptive. Le fournisseur suit ainsi les traces d’IBM et de D-Wave Systems – dont l’ordinateur quantique 2000Q est déjà construit et vendu à des clients comme le laboratoire national de Los Alamos et Google, entre autres.

Microsoft espère pouvoir développer des processeurs en recourant aux qubits topologiques, une forme plus stable de bits quantiques, plus résistants dans le cadre d’une utilisation quotidienne, indique-t-il. Dans le même temps, la firme dirigée par Satya Nadella développe un langage de programmation des bits quantiques qui utilise ce modèle. Le système sera disponible dans une préversion gratuite d’ici la fin de l’année. Cela inclura des bibliothèques et des tutoriels pour que les développeurs puissent se familiariser avec l’informatique quantique. Cette approche est similaire à celle d’IBM dont l’ordinateur quantique 5-qubit est déjà accessible dans le cloud pour qui veut le découvrir.

Le marché des serveurs fait grise mine en Europe de l'Ouest

June 08, 2017

Le marché des serveurs continue de s'enliser et a entamé 2017 comme il avait terminé 2016 : en baisse. Après avoir chuté de 4,6% dans le monde au cours du quatrième trimestre de l'an passé, les ventes ont connu un recul strictement similaire au premier trimestre de cette année pour atteindre 11,8 Md$, selon IDC. Pour le cabinet d'études, cette contre-performance s'explique notamment par une baisse de la demande des fournisseurs de services hébergés en matière de systèmes haut de gamme. Ils semblent préférer attendre le déploiement des dernières puces Intel Skylake pour renouveler ou étoffer leurs parcs de serveurs. La fluctuation du prix de la DRAM les pousse également à l'attentisme.

L'appétence pour les produits moins évolués n'a en revanche pas baissé puisque les livraisons de serveurs ont globalement crû d'1,4% à 2,21 millions d'unités entre janvier et mars derniers. Dans ce contexte, les dispositifs de milieux de gamme sont les seuls à avoir tiré leur épingle du jeu. Leurs ventes ont progressé de 16,5% à 1,3 Md$ tandis que celles des systèmes d'entrée de gamme et haut de gamme déclinaient respectivement de 3,4% (9,5 Md$) et 29% (1 Md$).

Une erreur humaine à l'origine de la panne géante chez British Airways

June 07, 2017

(màj) On connait maintenant l’origine de la panne informatique qui a entraîné des centaines de retards ou d’annulations dans les vols le 27 mai à l’aéroport britannique d’Heathrow. Il s'agit d'une erreur humaine, ainsi que l'établit l’enquête indépendante demandée par British Airways. Celle-ci indique qu'un technicien, apparemment un électricien travaillant pour un sous-traitant, a éteint puis rallumé l’alimentation électrique du datacenter de la compagnie aérienne, rapporte le quotidien The Guardian. British Airways a en effet outsourcé une partie de ses équipes informatiques dans le cadre d'un programme de réduction de coûts. Selon Willie Walsh, DG d’IAG, maison mère de la compagnie, le technicien était autorisé à se trouver dans la pièce en question mais pas à « faire ce qu’il a fait ». L’alimentation du datacenter a été restaurée d’une façon incontrôlée qui a provoqué des dommages physiques aux serveurs et aux armoires de distribution électrique, a expliqué le dirigeant.

Willie Walsh a reconnu par ailleurs que la communication de la compagnie aérienne vis-à-vis des voyageurs avait été très mauvaise. 75 000 voyageurs ont été affectés d’une façon ou d’une autre par les dysfonctionnements informatiques ainsi générés.

Une panne électrique dans un datacenter British Airways provoque le chaos à Heathrow

May 30, 2017

Un accident majeur survenu dans un datacenter de British Airways a mis en évidence l'importance pour les entreprises de tester leurs systèmes de sauvegarde et leurs procédures de récupération après sinistre afin de vérifier que ceux-ci fonctionnent comme prévu. Selon le CEO Alex Cruz, la compagnie aérienne britannique a subi une « panne majeure de ses systèmes informatiques », laquelle a affecté tous ses systèmes d'enregistrement et ses systèmes opérationnels. La panne, survenue samedi 27 mai, a provoqué le retard ou l'annulation de centaines de vols, bloquant des milliers de passagers à l'aéroport londonien de Heathrow – le plus important d’Europe - pendant un week-end férié.

Deux jours plus tard, la situation n’était toujours pas rétablie. Le CEO a simplement parlé de « problème électrique », sans entrer dans les détails, pour expliquer la nature de la panne. Mais une porte-parole de British Airways a évoqué « un problème d'alimentation dans un des datacenters de la compagnie, localisé en Angleterre ». Ajoutant : « une surtension d’une puissance exceptionnelle a entrainé des dommages physiques sur notre infrastructure et un grand nombre de nos systèmes informatiques opérationnels extrêmement complexes sont tombés en panne ». Elle a précisé que l’entreprise avait bien un système de restauration, mais que « celui-ci n’avait pas fonctionné ».

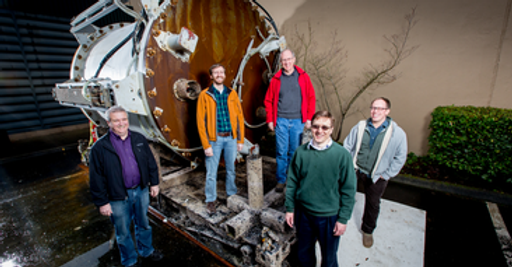

13 ans après l'ébauche du concept, HPE a dévoilé son premier prototype à part entière de The Machine dans un laboratoire au Colorado.

May 16, 2017

En 2004, Kirk Bresniker, architecte en chef chez HP Labs, s'est engagé à apporter des changements radicaux à l'architecture informatique avec The Machine et a dessiné le premier concept sur un tableau blanc. À l'époque, il voulait construire un système capable de transporter l'informatique vers l'avenir. L'objectif était de construire un ordinateur utilisant des technologies de pointe comme les memristors et les connexions photoniques. Ce fut un voyage ardu, mais HPE a finalement montré un prototype de The Machine dans un laboratoire à Fort Collins, au Colorado.

Si ce prototype est plutôt éloigné de ce que l'entreprise envisageait avec The Machine lorsque le projet a été officiellement annoncé en 2014, il suit le même principe pour la structure du sous-système mémoire. Il brise les limitations liées à l'architecture conventionnelle des PC et serveur dans laquelle la mémoire est un goulet d'étranglement, en exploitant une technologie appelée Memory-Driven Computing. La caractéristique exceptionnelle de ce méga-serveur est sa capacité mémoire de 160 To répartie sur 40 noeuds physiques - divisés en quatre boîtiers Apollo 6000 - interconnectés avec une architecture fabric utilisant une interconnexion haute performance.

La grande famille DellEMC se rassemble pour la première fois à Las Vegas pour une convention très attendue suite à l'absorption du géant du stockage par Michael Dell.

May 09, 2017

En direct de Las Vegas - Neuf mois après le rachat d’EMC par Dell, la grande famille est pour la première fois réunion à Las Vegas pour la traditionnelle convention du fournisseur. Près de 13 500 personnes – clients, partenaires et employés – sont attendues cette semaine à DellEMC World 2017 avec comme d’habitude des keynotes, des ateliers techniques, des passages de certification et son lot d’annonces. Et la greffe des solutions Dell au catalogue EMC – ou l’inverse c’est selon – entraine une avalanche de mises à jour dans le monde des infrastructures où DellEMC est devenu de facto le principal poids lourd. Michael Dell, 52 ans cette année, a réussi son pari en intégrant sans heurts la fédération EMC (EMC2, VMware, RSA et Pivota) pour placer sous la bannière Dell Technologies, dont il est le principal actionnaire, la famille recomposée : DellEMC, Pivotal, RSA/SecureWorks, VMware et Virtustream. Une intégration à marche forcée pour ne pas laisser le champ libre à la concurrence comme l’a expliqué Michael Dell. Et d’ici deux ans, Dell Technologies entend bien réussir à redistribuer les cartes dans les secteurs les plus prometteurs aujourd’hui, la transformation numérique des entreprises, l’IoT et les technologies au service de l’homme. Michael Dell qui se présente avec humour comme le mouton noir de la famille pour ne pas avoir fait médecine, est persuadé que la technologie peut changer la vie des hommes.

A 26°C, le datacenter de l'Université Rennes II ne répond plus

April 12, 2017

Alors que la température atteignait un niveau estival avec 26°C à Rennes ce week-end, l'université a annoncé lundi 10 avril 2017 sur Twitter une panne informatique grave dans son datacenter la veille, dimanche 9 avril 2017, avec une précision peu après. Nos confrères de Ouest-France ont indiqué des reports d'examens pour les épreuves de Lundi 10 et Mardi 11 avril 2017. « Nous gérons actuellement un retour à la normale » a confirmé le service communication de l'Université qui indique que celle-ci n'a eu à subir « aucune perte de données ».

La direction des Systèmes d'Information a refusé de répondre à nos questions et nous a renvoyé vers le service communication. Celui-ci a indiqué que, effectivement, il y avait eu une panne de la climatisation du datacenter. Le technicien d'astreinte a alors déclenché un arrêt d'urgence, procédure classique en tel cas. Mais il s'est révélé que la panne touchait « deux pièces identiques, une seule étant disponible sur Rennes, l'autre devant venir d'ailleurs en Europe ». La porte-parole n'a pas précisé la nature de cette pièce, ni même s'il s'agissait d'une pièce de la climatisation ou du matériel informatique lui-même.

L'hébergeur lyonnais Synaaps a choisi Paris pour localiser son troisième datacenter. Une quatrième implantation est par ailleurs prévue à Villeurbanne.

April 05, 2017

Synaaps Datacenter Technologies se rapproche des entreprises franciliennes. L'hébergeur lyonnais vient en effet de choisir le centre de Paris pour ouvrir un nouveau data center depuis lequel il va délivrer ses services d'IaaS, de PaaS et de housing. Cette installation est la troisième du type pour l'entreprise qui en opérait déjà une à Lyon depuis 2009 et une autre à Roanne depuis 2013. Ces trois infrastructures sont certifiées ISO 27001 et agréées pour le stockage des données de santé. En outre, elles sont équipées de dispositifs PRA et PCA natifs pour assurer la continuité des services même en cas d'incident majeur. Tout cela n'est pas de trop au regard des types de clients visés par Synaaps.

Avec son nouveau data center, l'hébergeur compte directement séduire les grands comptes de la place parisienne, aussi bien publics que privés. Ayant fait de de la sécurité et de la disponibilité son cheval de bataille, Synaaps n'a pas le droit à l'erreur. Et pour l'instant, le contrat semble rempli. La société compte aujourd'hui environ 200 clients et devrait poursuivre le déploiement de ses infrastructures. Un quatrième data center est en effet en construction à Villeurbanne.

Pour répondre aux problèmes des petites entreprises n'ayant pas le temps ou le budget - voire les deux - de créer une salle informatique, Schneider Electric propose des datacenters en containers amovibles. Le dernier modèle en date, Micro DC Express, est certifié pour les serveurs Cisco UCS et proposé à moins de 5 000 euros.

March 31, 2017

Spécialisé dans la gestion de l'énergie et des automatismes industriels, Schneider Electric propose un large éventail de produits, allant des disjoncteurs aux onduleurs (avec le rachat d'APC) en passant par des logiciels de mesure de la performance énergétique et également la mise en oeuvre de solutions pour connecter des bâtiments voire des villes (smart cities). Mais la société est également présente sur un créneau de niche, jugé cependant porteur, et en pleine croissance, à savoir les datacenters en boite. Tout comme les modèles un peu plus imposants, les datacenters conteneurisés ou modulaires, ces « mini datacenters » permettent aux petites entreprises dépourvues de salles informatiques, pour des besoins temporaires ou pérennes, de se doter d'une infrastructure IT clé en main et condensée dans un espace pour le moins restreint.

Les ventes de serveurs ont représenté 600 000 unités pour un chiffre d'affaires de 3,4 Md$ entre octobre et décembre derniers en EMEA.

March 15, 2017

La zone EMEA a été le maillon le plus faible du marché des serveurs (x86 et autres) à la fin 2016. Au cours du quatrième trimestre, les ventes de ces matériels s'y sont repliées de 12,9% à 3,4 Md$ par rapport à la même période en 2015. Quant aux livraisons, elles ont baissé de 4,7% pour atteindre 600 000 unités. En comparaison, le chiffre d'affaires mondial du secteur n'a parallèlement baissé « que » de 4,6% et ses volumes de 3,5% au cours de la même période. Un découpage plus fin des revenus des fabricants dans la zone EMEA montre que c'est en Europe Centrale et de l'Est que leurs facturations ont le plus chuté (-16,8% à 730,6 M$). Le coup le plus rude a néanmoins été porté par les résultats obtenus en Europe de l'Ouest (-11,8%) où est dégagé la plus grande partie des revenus du marché des serveurs en EMEA. C'est finalement le Moyen-Orient et l'Afrique qui s'en sortent le mieux avec un recul de chiffre d'affaires de 7,5%.

N'imaginez pas que vous pourrez utiliser des ordinateurs quantiques pour le courrier électronique ou le traitement de texte. Après des décennies de recherche, les premiers ordinateurs quantiques sont opérationnels. Mais à quoi peuvent-ils bien servir ? C'est la question à laquelle réfléchissent aujourd'hui constructeurs et développeurs.

March 14, 2017

IBM et D-Wave essayent de monétiser leurs coûteux ordinateurs quantiques en commercialisant des services. Les deux constructeurs s’accordent pour dire que les machines quantiques sont différentes des PC et ne peuvent pas être utilisées pour n’importe quel type d’application. Les systèmes quantiques sont destinés à des tâches que les ordinateurs actuels ne pourront jamais accomplir, comme la découverte de nouveaux médicaments et la construction de structures moléculaires. Les ordinateurs actuels sont très bien pour trouver des réponses en analysant des informations dans des ensembles de données existants, mais les systèmes quantiques peuvent obtenir plus de réponses en prenant en compte un plus grand nombre d’évènements.

Les machines quantiques peuvent être nettement plus rapides et pourraient éventuellement remplacer les ordinateurs et les serveurs actuels. L'informatique quantique permet aussi de faire un pas de plus et de dépasser les limites physiques et structurelles des systèmes existants. Il a fallu du temps pour en arriver là. Les chercheurs ont déjà trouvé des applications possibles pour les premiers ordinateurs quantiques comme le 2000Q de D-Wave, une machine à 2000-qubits, et pour les systèmes 5-qubits d'IBM. Les deux matériels sont basés sur des technologies différentes : le système d'IBM est complexe et plus avancé en termes de technologie, alors que le système de recuit quantique de D-Wave est plus pratique et permet une mise en œuvre plus rapide du calcul quantique. Et il est beaucoup plus rapide que les PC actuels.

Intel a commencé à faire tester sa dernière puce Itanium. Au cours du second semestre de cette année, HPE livrera des serveurs basés sur ce processeur haut de gamme et fonctionnant sous HP-UX, son système Unix propriétaire de HPE, ainsi que sous OpenVMS.

February 15, 2017

La survie de la puce Itanium d'Intel tient à un fil. Après plus de trois ans, le fondeur démarre la livraison de la prochaine version - sans doute la dernière - de son processeur, sous le nom de code Kittson. « Pour l’instant, la puce est fournie en test à certains clients, mais l’expédition en masse est programmée plus tard cette année », a déclaré un porte-parole de l'entreprise. Les puces Itanium ont été utilisées dans des mainframes et des serveurs critiques. Mais, Hewlett Packard Enterprise sera probablement un des seuls constructeurs à proposer plus tard cette année des serveurs intégrant Kittson.

La puce Itanium a été vouée à une mort lente et douloureuse, et Kittson enterrera très probablement la série. Les systèmes qui la supportent ont été réduits à la portion congrue et le développement logiciel a marqué le pas. Intel ne regrettera sans doute pas sa fin. Il recherche des marchés plus rentables, tentant par ailleurs de s’alléger de tous les produits qui ne répondent plus à sa nouvelle stratégie. Le fondeur a ouvertement exercé des pressions sur ses clients exploitant des Itanium pour qu'ils passent à des Xeon x86, lesquels dominent plus de 90% du marché des serveurs. Comme l’a déclaré Jim McGregor, analyste principal de Tirias Research, « Itanium est en mode maintenance et il y a peu de chance qu’il aille beaucoup plus loin ».

Une anomalie dans une ancienne puce Atom d'Intel provoque des plantages de serveurs et d'équipements réseau.

February 08, 2017

Une malfaçon découverte dans une ancienne puce d'Intel pourrait faire planter des serveurs et des équipements réseau. Le fondeur « prépare et valide un patch de silicium mineur » pour résoudre le problème. Le défaut, signalé pour la première fois par The Register, a été localisé dans des puces Atom C2000 livrées à partir de 2013. Un erratum ajouté en janvier par Intel à la documentation de la puce Atom C2000 prévient que les systèmes équipés de la puce « peuvent se trouver dans l’impossibilité de démarrer ou cesser de fonctionner ». Cette puce, la dernière de la série de processeurs Intel Atom basse consommation pour serveurs, équipe des microserveurs, mais aussi des équipements réseaux de fabricants comme Cisco. Ce dernier a d’ailleurs publié un avis pour signaler le défaut d’un composant dans un de ses produits ayant un impact sur les signaux d'horloge. La dégradation de ce signal d'horloge au fil du temps altère la capacité de la puce à exécuter les tâches.Intel essaye de résoudre le problème, mais n’a pas voulu dire à quel moment une mise à jour sera disponible. « Nous avons d’ores et déjà fourni à nos clients une solution de contournement au niveau de la carte », a déclaré un porte-parole d'Intel par courriel. « Par ailleurs, nous sommes en train de préparer et de valider un correctif de silicium mineur dans un nouveau produit [mise à jour] ». Le cycle de régénération moyen d’un serveur est de trois à cinq ans, mais la durée de vie du matériel réseau et de stockage dans lequel on trouve la puce C2000 est plutôt de cinq à 10 ans. Les entreprises utilisant la puce doivent contacter leur représentant ou leur fournisseur de système pour effectuer les mises à jour.

AMD dévoile Naples une déclinaison 32 coeurs pour serveur. Selon le fabricant, les premiers serveurs intégrant cette puce seront livrés au cours du premier semestre de cette année.

January 25, 2017

Lors du dernier CES (5 au 8 janvier), AMD avait lancé ses premières puces Zen Ryzen (huit cœurs) pour PC. Mais, une nouvelle version serveur de la puce avec 32 cœurs, nom de code Naples, est déjà en production et sera livrée dans les prochains mois. Bien que Naples n'ait pas encore de nom officiel, AMD attend beaucoup du nouveau processeur. Alors que la première puce Ryzen cible les PC, l’objectif de Naples est plus ambitieux : la nouvelle puce serveur veut rivaliser avec les très musclées puces Xeon d'Intel qui équipent la plupart des serveurs actuels. Pour susciter l'enthousiasme autour de Naples, AMD a entrepris une campagne de promotion extrêmement active qui reprend la stratégie de Ryzen : mettre en avant les performances de la puce Zen. Selon AMD, en terme de performance, le cœur processeur de la puce serveur Zen offrira les mêmes avantages que les puces Ryzen. Le fabricant affirme ainsi que sa nouvelle puce serveur, basée sur Zen, exécute 40 % d’instructions par cycle d’horloge de plus que sa puce précédente basée sur l'architecture Excavator, une donnée importante pour mesurer les performances d’un CPU. AMD insiste aussi sur le nombre élevé de cœurs - 32 - de Naples.

Comparativement, les puces Xeon d'Intel peuvent intégrer jusqu'à 24 cœurs. La puce Intel Xeon Phi pour supercalculateurs peut supporter jusqu'à 72 cœurs, mais elle n'est pas destinée aux serveurs sockets courants. « Quand il y a plus de cœurs, les serveurs peuvent exécuter plus de tâches. Ça fait une différence », a déclaré cette semaine dans un blog Forrest Norrod, vice-président senior et directeur général d’AMD. De plus en plus de données sont déplacées vers le cloud, et les serveurs installés dans les datacenters sont de plus en plus sollicités. « Le nombre élevé de cœurs apporte une puissance de traitement supplémentaire qui permettra aux serveurs de répondre rapidement aux requêtes, de reconnaître les images, de traiter les vidéos téléchargées. Avec un seul CPU Zen, un serveur pourra prendre en charge autant de tâches qu'un serveur actuel à deux sockets », a encore déclaré Forrest Norrod.

NEC propose une appliance virtuelle pour sa solution objet HydraStor 5

January 13, 2017

Pionnier sur le marché du stockage objet, NEC revient dans la course avec sa solution HydraStor 5, qui se décline sous la forme d'une appliance virtuelle pour VMware vSphere et Microsoft Hyper-V.

En direct de Santa Clara - Pas vraiment une start-up, le japonais NEC n’en reste pas moins une entreprise à la pointe de l’innovation dans le domaine des infrastructures IT. Active dans les domaines des serveurs, du réseau et du stockage, la société nous a accueilli dans ses locaux de Santa Clara, en Californie, pour détailler la dernière mouture de sa plate-forme HydraStor. Lancée en 2002, cette solution - issue des travaux réalisés par le laboratoire de recherche de NEC à Princeton - se présente comme une plate-forme distribuée de type objet pour la sauvegarde et l’archivage.

Les ventes de serveurs progressent mais en valeur seulement

December 29, 2016

Malgré la baisse des livraisons mondiales de serveurs HPC au troisième trimestre 2016, le chiffre d'affaires qu'elles ont généré a progressé grâce à la forte hausse des achats des produits les plus performants.

Les systèmes dédiés au calcul à haute performance offrent une bouffée d'oxygène à un marché mondial des serveurs en berne (-7% à 12,5 Md$ au T3 2006). Selon IDC, les livraisons de plates-formes HPC ont en effet représenté 2,8 Md$ de chiffre d'affaires entre juillet et septembre derniers, soit 3,9% de mieux qu'au troisième trimestre 2015. Elles ont ainsi permis aux fabricants d'empocher 8,1 Md$ de revenus (+3,4%) au cours des neuf premiers mois de 2016. Mais si les ventes ont progressé en valeur, elles ont néanmoins enregistré une baisse en volume de 11% à 63 400 unités durant ces trois trimestres.

Hausse de 16% du prix moyen

Cette disparité entre l'évolution de la valeur et celle des volumes s'explique par une demande très tournée vers les serveurs HPC haut de gamme. Cette tendance a d'ailleurs entraîné une hausse du prix moyen des produits. Il est passé de 109 280 $ au cours des neuf premiers mois de 2015 à 127 411 $ durant la même période cette année. S'agissant des plates-formes les plus performantes (500 K$ et plus), elles ont généré 985,3 M€ (+22,3%) de facturations au troisième trimestre 2016. La progression a été quasi équivalente pour les systèmes facturés entre 250 K$ et 499 K$, dont les revenus ont atteint 568,4 M$. En revanche, les chiffre d'affaires des serveurs HPC départementaux (100 K$ à 249 K$) et de ceux pour groupe de travail (moins de 100 K$) ont respectivement reculé de 14,4% (836,2 M$) et 8,7% (395,5 M$).

Les 10 tendances technologiques en 2017

December 02, 2016

Comme chaque année, la rédaction du Monde Informatique a établi une liste des 10 tendances technologiques à venir ou qui vont se poursuivre en 2017. Cette liste n'est bien sûr pas exhaustive mais elle reflète aussi la réalité du terrain à l'instar des expérimentations menées dans la 5G en France et à l'international ou l'émergence de la réalité augmentée pour mieux visualiser les données. Il ne s'agit pas non plus de fantasmer sur les prédictions à venir dans les cinq à dix ans à venir mais de donner quelques éléments de réponses sur l'impact des actions actuellement menées par certaines technologies comme le deep learning ou le protocole de réseau maillé Thread destiné aux objets connectés. Enfin, certaines solutions déjà existantes s'enrichissent également pour apporter plus d'agilité et une nouvelle expérience aux utilisateurs ou aux administrateurs comme les plateformes de communications unifiées qui s'orientent davantage vers la mobilité ou l'approche SD-WAN considérée comme une alternative ou un complément aux réseaux MPLS.

Sommaire du dossier :

1. Mieux visualiser les données avec la réalité augmentée

Et si la réalité augmentée était le moyen le plus simple et intuitif pour visualiser des données ! En juin dernier, à...

2. Bataille autour de la supervision des containers

Depuis sa relance open source en 2013 (les containers sont arrivés en 2004 avec Solaris 10), la containerisation des applications avec Docker ou CoreOS est un...

3. Thread, un réseau maillé pour l'IoT

Les milliards d’objets connectés annoncés par les différents cabinets d’études dans les cinq ans à venir vont envahir...

4. Le grand bond en avant du deep learning

Les 24 et 25 octobre derniers s’est tenue à Reims une formation sur le deep learning organisée par l'Université de Reims Champagne-Ardenne...

5. Des communications unifiées résolument tournées vers la mobilité

Face à des utilisateurs professionnels de plus en plus dépendants des terminaux mobiles et qui délaissent les classiques solutions de...

6. L'hyperconvergence sur la voie de la maturité

Deux milliards d’euros, c’est le chiffre d’affaires mondial en 2016 généré par les systèmes hyperconvergés selon le...

7. SD-WAN, une alternative ou une complémentarité aux liens MPLS ?

Pour une entreprise multi-sites, le réseau MPLS (Multiprotocol label switching) en place depuis plus de 15 ans n’est plus forcément adapté au...

8. Cloud hybride : la voie de la raison

Selon IDC, les souscriptions aux offres de cloud public devraient représenter 38,6 Md€ d'ici quatre ans contre 15 Md€ en 2015 en Europe de l'Ouest, soit...

9. Sécurité : Cap sur les outils d'analyses comportementales

Lors de l’IT Tour 2016, la rédaction du Monde Informatique a pu constater l’importance du nombre des attaques de type crytolockers auxquelles les...

10. Cap sur la 5G

La 5G ne verra pas commercialement le jour avant 2020-2025, sa standardisation définitive n’est d’ailleurs pas encore à l’ordre du jour...

L'informatique quantique en tête des priorités de Microsoft

November 22, 2016

L'informatique quantique dépassera largement les PC et les serveurs actuels. C'est la conviction de la firme de Redmond qui compte proposer un jour prochain du hardware et des logiciels quantiques.

Voilà plus d'une décennie que Microsoft travaille sur l'informatique quantique. Aujourd’hui, l'objectif de l'entreprise est de mettre ces théories en pratique et elle multiplie ses efforts pour créer le hardware et les logiciels qui serviront de base à un futur ordinateur quantique. Pour diriger le développement de ce hardware et de ces logiciels quantiques, Microsoft a déjà nommé Todd Holmdahl, impliqué auparavant dans le développement des technologies Kinect, HoloLens, et Xbox. La firme de Redmond a également embauché quatre éminents professeurs d'université pour contribuer à cette recherche : Leo Kouwenhoven, professeur à l'université de technologie de Delft aux Pays-Bas ; Charles Marcus, professeur à l'Université de Copenhague ; Matthias Troyer, professeur à l'ETH de Zurich ; et David Reilly, professeur à l'Université de Sydney en Australie. Tous conservent leurs titres officiels de professeur.

En théorie, les ordinateurs quantiques peuvent nettement dépasser les supercalculateurs actuels. La finalité étant de créer des ordinateurs quantiques universels capables de faire tourner tous les programmes existants et de réaliser des calculs aussi variés que les ordinateurs actuels. Les tout premiers ordinateurs quantiques savent faire tourner un nombre limité d'applications. Des entreprises comme IBM, D-Wave et Google mènent également leurs propres recherches sur l'informatique quantique. Selon les chercheurs d'IBM, qui essayent également de créer des hardwares capables de résoudre des problèmes spécifiques, il ne faut pas espérer voir un ordinateur quantique universel avant quelques décennies.

Des circuits quantiques encore à créer

Les ordinateurs quantiques de D-Wave et d’IBM sont fondés sur des bases théoriques différentes, et chaque entreprise jugea son approche meilleure que celle de son concurrent. D-Wave a une forte politique d’incitation des programmeurs. L’entreprise espère qu’en incitant le plus de développeurs à tester son matériel, elle favorisera les usages de son matériel.

On ne sait pas dans combien de temps Microsoft pourra livrer un hardware quantique. Comme les autres fabricants, l’entreprise va devoir créer les circuits quantiques sur lesquels elle pourra tester ses applications et commencer à s'attaquer à des problèmes comme la correction d'erreurs, la tolérance aux pannes et la perte de signal. Les hardwares opérationnels ne seront livrés qu'après la résolution d'un certain nombre de problèmes de calcul quantique. Mais Microsoft propose déjà une boîte à outils logicielle qui permet de simuler un ordinateur quantique. Les ordinateurs conventionnels traitent des données binaires composées de chaînes de 0 et de 1. Cependant, les ordinateurs quantiques sont beaucoup plus complexes : ils tournent avec des processeurs qubits qui exploitent les lois de la mécanique quantique pour atteindre différents états.

Top500 des supercalculateurs: La France perd des places

November 14, 2016

Au classement Top500 des supercalculateurs, la première place française revient au système Pangea de Total classé 16e alors qu'il pointait en 11e position en juin dernier. La Chine occupe toujours le haut du classement avec ses systèmes Sunway TaihuLight et Tianhe-2.

L'édition automnale du classement des supercalculateurs Top500 est loin de rendre hommage aux titanesques efforts de tout l'écosystème français du supercomputing et de l'exascale, chercheurs en tête. C'est même la douche froide avec un recul global par rapport à juin dernier sur les positions françaises au classement. Alors qu'il pointait à la 11e place en juin dernier, le système Pangea de Total (5,3pflops) a reculé de 5 places pour glisser en 16e position. Idem pour les systèmes français qui suivent comme ceux de Météo France, du CEA ou encore du Genci et d'Atos, qui perdent également de précieuses places entre novembre 2016 et juin 2016.

Pour autant, le nombre de supercalculateurs que la France parvient à maintenir aux 100 premières places reste inchangé, avec 10 machines. Sur l'ensemble du TOP500, l'Hexagone réussit cependant sur un an à placer 20 supercalculateurs par rapport aux 18 de novembre 2015 alors que, maigre consolation, l'Allemagne a au contraire reculé légèrement en passant de 33 à 31 supercalculateurs.

Le DATACENTER on a chip se développe

October 11, 2016

Une équipe de recherche de l’Université d’Etat de Washington a élaboré un datacenter minuscule qui pourra tenir un jour dans la main et réduire ainsi la consommation énergétique des centres de calcul.

Une équipe de recherche de l’Université d’Etat de Washington a élaboré un datacenter minuscule, qui un jour pourra tenir dans la main et réduire ainsi la consommation énergétique des centres de calcul.

Au cœur de cette idée, il y a un changement de paradigme dans la gestion des grands volumes de données, explique Partha Pratim Pande, professeur de génie informatique. Avec la collaboration du professeur Deuk Heo de l’Université de Washington et une équipe de l’Université Carnegie Mellon, il a présenté un design préliminaire de datacenter on a chip à la conférence Embedded Systemes à Pittsburgh. Les chercheurs ont reçu une subvention de la la NSF (National Science Foundation) de 1,2 million de dollars pour développer ce concept.

Les centres de calculs et les centres HPC sont extrêmement gourmands en énergie et en espace.

Microsoft expérimente un data center sous-marin

February 02, 2016

Les chercheurs de la firme de Redmond étudient sérieusement la possibilité de déployer des centres de données dans les fonds marins. Un premier prototype a été testé en août dernier au large des côtes de Californie. Une deuxième vague d'expérimentations devrait débuter au cours de cette année avec un prototype trois fois plus grand.

De nombreux géants du web privilégient les pays nordiques pour y implanter leurs centres de données afin de diminuer leurs dépenses consacrées au refroidissement. Microsoft, lui, expérimente une autre piste. Celle des océans. Lundi 1er février, le New York Times a révélé que la firme de Redmond planchait sur le Project Natick. Il s’agit d’un projet de recherche qui vise à créer des datacenters sous-marins.

L’idée n’est pas nouvelle. En effet, le projet a débuté en 2013 après que deux employés d’un datacenter de Microsoft ont écrit un livre blanc pour présenter ce concept.